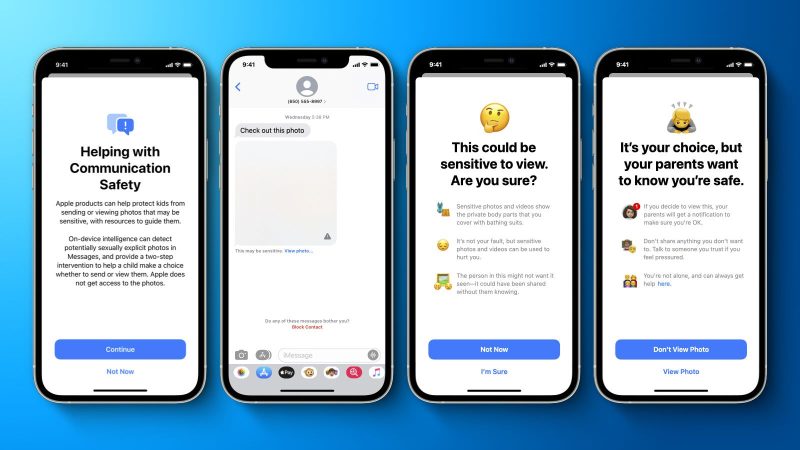

Appleが児童性的虐待コンテンツ(Child Sexual Abuse Material = CSAM)を防止する機能の実装を断念した。WIREDに寄せられた公式声明文によると、Appleは昨年12月に発表した、子どもを保護するコミュニケーションセーフティ機能にさらなる投資を行うと宣言。その上で、…

The post Apple、iCloud写真の児童性的虐待コンテンツを検出する機能を断念 first appeared on ゴリミー.

【もっと読む】

Source: ゴリミー

Appleが児童性的虐待コンテンツ(Child Sexual Abuse Material = CSAM)を防止する機能の実装を断念した。WIREDに寄せられた公式声明文によると、Appleは昨年12月に発表した、子どもを保護するコミュニケーションセーフティ機能にさらなる投資を行うと宣言。その上で、…

The post Apple、iCloud写真の児童性的虐待コンテンツを検出する機能を断念 first appeared on ゴリミー.

【もっと読む】

Source: ゴリミー